Истерия по поводу будущего искусственного интеллекта (ИИ) повсюду. Вот как это сделать.

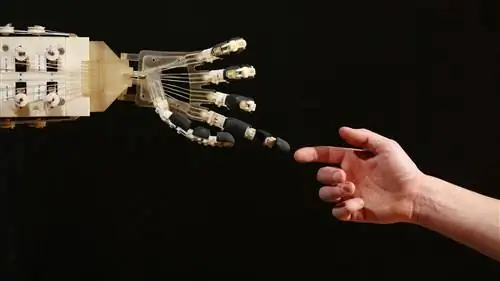

Истерия по поводу будущего искусственного интеллекта (ИИ) повсюду. Кажется, нет недостатка в сенсационных новостях о том, как ИИ может лечить болезни, ускорять человеческие инновации и улучшать человеческое творчество. Просто глядя на заголовки СМИ, можно подумать, что мы уже живем в будущем, когда ИИ проник во все сферы жизни общества.

Хотя нельзя отрицать, что ИИ открыл множество многообещающих возможностей, он также привел к появлению мышления, которое лучше всего можно описать как «решение ИИ». Это философия, что при наличии достаточного количества данных алгоритмы машинного обучения могут решить все проблемы человечества.

Но с этой идеей есть большая проблема. Вместо того, чтобы поддерживать прогресс ИИ, он фактически ставит под угрозу ценность машинного интеллекта, игнорируя важные принципы безопасности ИИ и создавая нереалистичные ожидания относительно того, что ИИ действительно может сделать для человечества.

Решение ИИ

Всего за несколько лет подход к решениям в области ИИ перекочевал из уст технологических евангелистов Кремниевой долины в умы государственных чиновников и политиков по всему миру. Маятник качнулся от антиутопического представления о том, что ИИ уничтожит человечество, к утопической вере в то, что наш алгоритмический спаситель уже здесь.

Сейчас мы видим, как правительства обещают поддержку национальным инициативам в области искусственного интеллекта и соревнуются в технологической и риторической гонке вооружений, чтобы доминировать в растущем секторе машинного обучения. Например, правительство Великобритании пообещало инвестировать 300 миллионов фунтов стерлингов в исследования ИИ, чтобы позиционировать себя как лидера в этой области. Впечатленный преобразующим потенциалом ИИ, президент Франции Эммануэль Макрон взял на себя обязательство превратить Францию в глобальный центр ИИ. Между тем, китайское правительство наращивает свое мастерство в области искусственного интеллекта с помощью национального плана по созданию китайской индустрии искусственного интеллекта стоимостью 150 миллиардов долларов США к 2030 году.

Нейронные сети - легче сказать, чем сделать

В то время как многие политические манифесты рекламируют преобразующие эффекты надвигающейся «революции ИИ», они, как правило, недооценивают сложность развертывания передовых систем машинного обучения в реальном мире.

Одной из самых перспективных разновидностей технологий искусственного интеллекта являются нейронные сети. Эта форма машинного обучения в общих чертах смоделирована по образцу нейронной структуры человеческого мозга, но в гораздо меньших масштабах. Многие продукты на основе ИИ используют нейронные сети для вывода шаблонов и правил из больших объемов данных. Но чего многие политики не понимают, так это того, что простое добавление нейронной сети к проблеме не означает автоматически, что вы найдете решение. Точно так же добавление нейронной сети к демократии не означает, что она мгновенно станет более инклюзивной, справедливой или персонализированной.

Борьба с бюрократией данных

Системам искусственного интеллекта для работы требуется много данных, но в государственном секторе обычно нет соответствующей инфраструктуры данных для поддержки расширенного машинного обучения. Большая часть данных остается в автономных архивах. Те немногие существующие оцифрованные источники данных, как правило, погребены под бюрократией. Чаще всего данные распределяются между различными государственными ведомствами, для доступа к каждому из которых требуются специальные разрешения. Прежде всего, государственному сектору обычно не хватает человеческих талантов с нужными технологическими возможностями, чтобы в полной мере воспользоваться преимуществами машинного интеллекта.

По этим причинам сенсация вокруг ИИ привлекла многих критиков. Стюарт Рассел, профессор компьютерных наук в Беркли, уже давно выступает за более реалистичный подход, который фокусируется на простых повседневных приложениях ИИ, а не на гипотетическом поглощении сверхразумными роботами. Точно так же профессор робототехники Массачусетского технологического института Родни Брукс пишет, что «почти всем инновациям в робототехнике и искусственном интеллекте требуется гораздо больше времени для действительно широкого развертывания, чем думают люди в этой области и за ее пределами».

Одна из многих трудностей при развертывании систем машинного обучения заключается в том, что ИИ чрезвычайно восприимчив к атакам со стороны противника. Это означает, что злонамеренный ИИ может нацелиться на другой ИИ, чтобы заставить его делать неверные прогнозы или вести себя определенным образом. Многие исследователи предостерегают от развертывания ИИ без соответствующих стандартов безопасности и защитных механизмов. Тем не менее безопасность ИИ остается темой, которую часто упускают из виду.

Машинное обучение - это не волшебство

Если мы хотим воспользоваться преимуществами и свести к минимуму потенциальный вред ИИ, мы должны начать думать о том, как машинное обучение может быть осмысленно применено к конкретным областям правительства, бизнеса и общества. Это означает, что нам нужно обсудить этику ИИ и недоверие многих людей к машинному обучению.

Самое главное, мы должны знать об ограничениях ИИ и о том, где люди все еще должны взять на себя инициативу. Вместо того, чтобы рисовать нереальную картину мощи ИИ, важно сделать шаг назад и отделить фактические технологические возможности ИИ от магии.

Долгое время Facebook считал, что такие проблемы, как распространение дезинформации и разжигание ненависти, можно выявить и остановить с помощью алгоритмов. Но под недавним давлением законодателей компания быстро пообещала заменить свои алгоритмы армией из более чем 10 000 человек-рецензентов.

Медицина также признала, что ИИ не может считаться решением всех проблем. Программа IBM Watson for Oncology была частью ИИ, предназначенной для помощи врачам в лечении рака. Несмотря на то, что он был разработан для предоставления наилучших рекомендаций, людям-экспертам было трудно доверять машине. В результате от программы ИИ отказались в большинстве больниц, где она проходила испытания.

Аналогичные проблемы возникли в юридической сфере, когда алгоритмы использовались в судах США для вынесения приговоров преступникам. Алгоритм подсчитывал баллы оценки риска и консультировал судей по вынесению приговора. Было обнаружено, что система усиливает структурную расовую дискриминацию, и позже от нее отказались.

Эти примеры демонстрируют, что не существует решения ИИ для всего. Использование ИИ просто ради ИИ не всегда может быть продуктивным или полезным. Не каждую проблему лучше всего решать, применяя к ней искусственный интеллект. Это важный урок для всех, кто стремится увеличить инвестиции в национальные программы искусственного интеллекта: все решения имеют свою цену, и не все, что можно автоматизировать, должно быть автоматизировано.

Вячеслав Полонский, научный сотрудник Оксфордского университета