Искусственный интеллект скоро станет достаточно мощным, чтобы работать автономно, как мы должны сказать ему действовать? Какой этике мы должны учить его?

Мы быстро приближаемся к тому дню, когда автономному искусственному интеллекту, возможно, придется принимать важные этические решения без человеческого контроля. Вопрос, на который мы должны ответить, заключается в том, как он должен действовать, когда на кону стоит жизнь.

Помогает нам принять решение философ Джеймс Х. Мур, один из первых философов, сделавших значительный вклад в компьютерную этику. В своем эссе 2009 года «Четыре вида этичных роботов» он исследует возможную этическую ответственность машин и то, как мы должны думать об этом.

Доктор. Мур классифицирует машины всех видов на четыре этические группы. Каждая группа обладает различными этическими способностями, которые нам необходимо учитывать при их разработке и реагировании на них.

Агенты этического воздействия

Это такие устройства, как часы, которые могут оказывать положительное или отрицательное влияние на человека. В то время как часы не могут ничего сделать, кроме как сказать мне, который час, часы могут ошибаться, и поэтому я опаздываю.

Неявные этические агенты

Это машины, подобные банкоматам, в конструкции которых учтены определенные этические проблемы. У банкоматов, например, есть гарантии, что они выдают правильную сумму денег, и они справедливы как для вас, так и для банка.

Другие машины могут быть неявно порочными, например, устройство для пыток, разработанное для обеспечения максимальной боли и отказоустойчивости против комфорта. Хотя у этих машин есть определенные этические черты, они являются частью самого существа машины; а не результат процесса принятия решений.

Явные этические агенты

Это ближе к тому, что думает большинство из нас, когда мы думаем о программируемых роботах и искусственном интеллекте. Эти устройства и машины можно «рассматривать как действующие исходя из этики, а не только в соответствии с этикой».

Если снова использовать пример с банкоматом, хотя банкомат должен проверить ваш баланс, прежде чем вы сбежите со всеми деньгами банка, он не решает сделать это, потому что программист дал ему этического кодекса, было прямо сказано проверить.

Явным этическим агентом будет банкомат, которому было сказано всегда предотвращать кражу, а затем он решил проверить ваш баланс, прежде чем дать вам миллион долларов, о котором вы просили, чтобы он мог достичь этой цели.

Этические агенты

Эти существа функционируют так же, как и мы, включая свободную волю и чувство собственного достоинства. Полностью моральное существо, биологическое или нет.

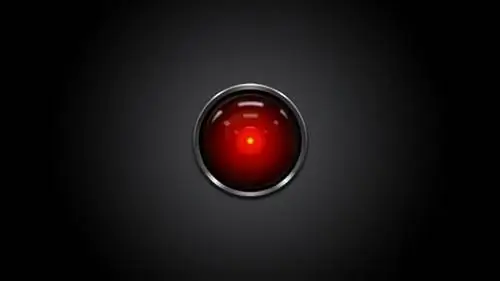

Можно с уверенностью сказать, что ни одна машина в настоящее время не соответствует этому обозначению, и большая часть академических и популярных дискуссий сосредоточена на явных этических агентах. Однако идея полностью этичного устройства завораживает, и ее можно найти в таких работах, как «2001: Космическая одиссея».

Итак, если нам нужно беспокоиться о явных агентах, как мы должны заставить их действовать?

Основной проблемой компьютерной этики является то, каким алгоритмам должен следовать явный этический агент. Хотя многие писатели-фантасты, философы и футуристы уже предлагали наборы правил, многие из них отсутствуют.

Доктор. Мур приводит в пример три правила робототехники Айзека Азимова. Для тех, кто нуждается в обновлении, они:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму законам.

Правила иерархичны, и все роботы в книгах Азимова обязаны им следовать.

Доктор. Мур предполагает, что проблемы с этими правилами очевидны. Первое правило настолько общее, что искусственный интеллект, следующий им, «может быть обязан по Первому закону бродить по миру, пытаясь предотвратить причинение вреда людям», и, следовательно, бесполезен для своей первоначальной функции!

Такие проблемы могут быть распространены в деонтологических системах, где следование хорошим правилам может привести к забавным результатам. Сам Азимов написал несколько рассказов о возможных проблемах с законами. Попыток решить эту проблему предостаточно, но проблема создания достаточного количества правил, охватывающих все возможности, остается.

С другой стороны, машину можно запрограммировать так, чтобы она придерживалась утилитарных расчетов при столкновении с этической проблемой. Это было бы просто сделать, поскольку компьютеру нужно было бы только дать переменную и сказать, чтобы он делал выбор, который максимизировал бы ее появление. В то время как человеческое счастье является обычным выбором, богатство, благополучие или безопасность также возможны.

Однако мы можем получить то, о чем просим. ИИ может решить максимизировать безопасность человека, сделав все рискованные технологии, к которым он имеет доступ, останавливающими. Можно было бы определить, что человеческое счастье достигает наивысшего уровня, когда всех несчастных людей отправляют в озера на беспилотных автомобилях.

Как мы можем судить машины, которые не делают выбора? Что может сделать этичную машину хорошей?

Это хитрый вопрос. Хотя мы считаем ответственными людей, утверждающих, что они «просто выполняли приказы», мы делаем это, потому что предполагаем, что у них была свободная воля поступить иначе. С А. И. нам не хватает этой способности. Однако доктор Мур считает, что мы все еще можем судить о том, насколько хорошо машина принимает решение.

Он говорит, что: «В принципе, мы могли бы собирать данные об этической компетентности робота так же, как мы собираем данные о компетентности людей, принимающих решения, сравнивая их решения с решениями людей или иначе. попросив робота обосновать свои решения.”

Хотя это не охватит все аспекты этического принятия решений, это будет хорошим началом для устройства, которое может следовать только алгоритму. Этот элемент не так уж и плох, д-р Мур несколько оптимистично оценивает способность таких машин делать трудный выбор, поскольку они могут принимать трудные решения «более компетентно и справедливо, чем люди».

По мере того, как искусственный интеллект становится умнее, а наша зависимость от технологий становится все более очевидной, потребность в компьютерной этике становится все более насущной. Если мы не можем прийти к соглашению о том, как должны действовать люди, как мы когда-нибудь примем решение о том, как должна функционировать разумная машина? Мы должны быстро принять решение, так как прогресс ИИ не показывает признаков замедления.