Бюллетень ученых-атомщиков опасается, что технологические достижения не останавливаются. Группа просит создать регулирующие органы для помощи в оценке и предотвращении рисков.

Бюллетень ученых-атомщиков решил держать стрелки Часов Судного дня на отметке без трех минут до полуночи. Это решение должно было выразить разочарование в связи с тем, что мир не предпринял решительных действий для сдерживания изменения климата и риска ядерной катастрофы. Ниже в списке потенциальных катастроф находится беспокойство о том, что прорывные технологические достижения останутся бесконтрольными.

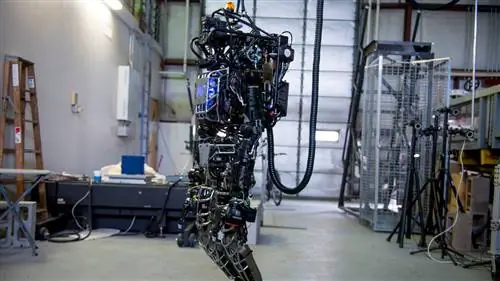

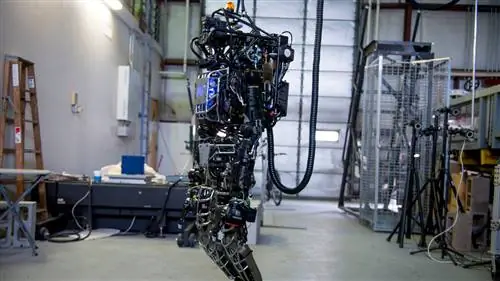

«Понятно, что достижения в области биотехнологии; в искусственном интеллекте, особенно для использования в роботизированном оружии; а в киберпространстве все потенциально может создать риск глобального масштаба», - написала группа.

Бюллетень признает достижения в области искусственного интеллекта, способные принести человечеству большую пользу, но также и большой вред. такой быстрый темп отчасти благодаря глубокому обучению, но правление и самые яркие умы мира дали повод для беспокойства.

Страх перед корпоративной катастрофой, подобной Скайнету, был в умах многих блестящих мыслителей. Это был такой обеспокоенность Илона Маска тем, что он помог основать OpenAI, некоммерческую исследовательскую компанию по искусственному интеллекту. Он был основан на убеждении, что «важно иметь ведущее исследовательское учреждение, которое может поставить во всех отношениях хороший результат выше своих собственных интересов». Это учреждение поможет создать место для развития без возможности неправомерного использования нерегулируемым государственным, научным или корпоративным учреждением.

«Там, где технология подталкивает, конфликт развивается настолько быстрее, чем способность наших систем адаптировать и регулировать его, что это станет для нас настоящим испытанием в ближайшие 10-15 лет».

Даже исследования, проведенные людьми с добрыми намерениями, могут пойти не так. Возможно, они раздвигают границы науки, не задумываясь, стоит ли им этим заниматься.

Ученые снова и снова указывали на то, что прогресс - палка о двух концах. Больше технологических достижений означает повышение уровня жизни, но также означает, что мы создаем ряд «новых способов, которыми что-то может пойти не так»,по словам Стивена Хокинга.

Однако Лоуренс Краусс не уверен, что есть повод для немедленного беспокойства.

«Илон Маск и другие, выразившие обеспокоенность, и Стивен Хокинг - мои друзья, и я понимаю их потенциальные опасения, но я, честно говоря, не так обеспокоен ИИ в по крайней мере, в ближайшем будущем, как и многие мои друзья и коллеги», - говорит Краусс, который является председателем совета спонсоров Bulletin.

“ Мы, конечно, должны понимать, что скорость, с которой машины развиваются в своих возможностях, может намного превышать скорость, с которой общество способно с ними справляться, он сказал.

По этой причине Хокинг сказал: «Важно убедиться, что эти изменения идут в правильном направлении. В демократическом обществе это означает, что каждый должен иметь базовое понимание науки, чтобы принимать обоснованные решения о будущем».

Совет по науке и безопасности считает, что международное сообщество должно создать институт для проверки и регулирования этих новых технологий для оценки любых рисков. До сих пор эти технологии практически не подвергались надзору, поэтому обществу приходится просить об этих регуляторах.