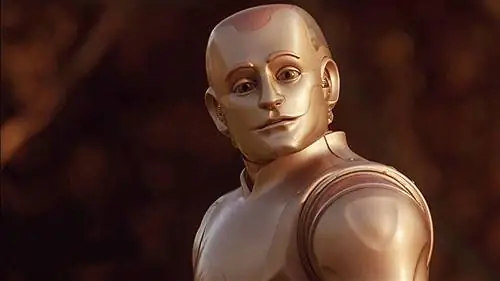

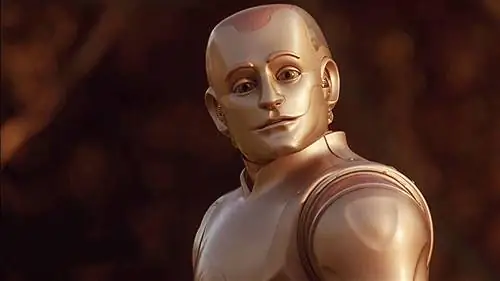

Мы несем прямую ответственность за радость, страдания, задумчивость и творческий потенциал наших роботов.

Down погружает HotBot 4b в вулкан. На дворе 2050 или 2150 год, и искусственный интеллект достаточно продвинулся, чтобы можно было создавать таких роботов с интеллектом, творчеством и желаниями человеческого уровня. HotBot теперь погибнет во время этой научной миссии. Есть ли у него права? Приказав ему спуститься, мы сделали что-то аморальное?

Моральный статус роботов - частая тема в научной фантастике, по крайней мере, начиная с рассказов Айзека Азимова о роботах, и консенсус ясен: если когда-нибудь нам удастся создать роботов, мысленная жизнь которых подобна нашей,, с человеческими планами, желаниями и самоощущением, включая способность радоваться и страдать, эти роботы заслуживают морального отношения, аналогичного тому, которое предоставляется естественным людям. Философы и исследователи искусственного интеллекта, писавшие об этом, в целом согласны.

Я хочу бросить вызов этому консенсусу, но не так, как вы могли предположить. Я думаю, что если мы когда-нибудь создадим роботов с человеческими когнитивными и эмоциональными способностями, мы должны будем относиться к ним с большей моральной ответственностью, чем обычно должны относиться к подобным людям.

И вот почему: мы будем их создателями и дизайнерами. Таким образом, мы несем прямую ответственность как за их существование, так и за их счастливое или несчастливое состояние. Если робот напрасно страдает или не может реализовать свой потенциал развития, это будет в значительной степени из-за нашей неудачи - неудачи в нашем создании, дизайне или заботе о нем. Наше моральное отношение к роботам будет больше похоже на отношение родителей к своим детям или богов к созданным ими существам, чем отношение между незнакомыми людьми.

В каком-то смысле это не более чем равенство. Если я создаю ситуацию, которая подвергает других людей риску, например, если я уничтожаю их посевы, чтобы построить аэродром, то у меня есть моральное обязательство выплатить им компенсацию, большее, чем мое обязательство перед людьми, с которыми у меня нет причинно-следственной связи. Если мы создаем по-настоящему сознательных роботов, мы оказываемся с ними глубоко причинно-следственными, и поэтому существенно ответственны за их благополучие. В этом корень нашего особого обязательства.

Чудовище Франкенштейна говорит своему создателю Виктору Франкенштейну:

Я твое создание, и я буду даже кроток и послушен моему природному господину и королю, если ты также исполнишь свою часть, которую ты должен мне. О, Франкенштейн, не будь равнодушен ко всем остальным и попирай меня одного, которому твоя справедливость и даже твое милосердие и привязанность больше всего подобают. Помни, что я твоя тварь: я должен быть твоим Адамом….

Мы должны либо создавать роботов, достаточно простых, чтобы мы знали, что они не заслуживают морального рассмотрения, как и все существующие сегодня роботы, либо мы должны создавать их только осторожно и заботливо.

Наряду с этой обязанностью проявлять заботу приходит другая, обязанность познания - обязанность знать, какие из наших творений действительно сознательны. Какие из них обладают реальными потоками субъективного опыта и способны к радости и страданию или к познавательным достижениям, таким как творчество и ощущение себя? Без таких знаний мы не будем знать, какие обязательства у нас есть перед нашими творениями.

Но как мы можем приобрести соответствующие знания? Как отличить, например, настоящий поток эмоциональных переживаний от смоделированных эмоций в искусственном разуме? Просто запрограммировать поверхностную симуляцию эмоций недостаточно. Если я вставлю стандартный компьютерный процессор, выпущенный в 2015 году, в игрушечного динозавра и запрограммирую его говорить «Ой!», когда я нажму на кнопку выключения, я не создам робота, способного страдать. Но какая именно обработка и сложность необходимы, чтобы породить подлинно человеческое сознание? С точки зрения некоторых взглядов - например, Джона Серла - сознание может быть невозможным ни в одном запрограммированном объекте; для этого может потребоваться структура, биологически подобная человеческому мозгу. Другие взгляды гораздо более либеральны в отношении условий, достаточных для сознания роботов. Научное изучение сознания все еще находится в зачаточном состоянии. Вопрос остается открытым.

Если мы продолжим разработку сложных форм искусственного интеллекта, у нас есть моральное обязательство улучшить наше понимание условий, при которых может действительно возникнуть искусственное сознание. В противном случае мы рискуем моральной катастрофой - либо катастрофой принесения в жертву своих интересов существам, не заслуживающим морального внимания, потому что они только ложно переживают счастье и страдание, либо катастрофой неспособности распознать страдания робота и, таким образом, непреднамеренного совершения злодеяний, равносильных рабству и убийство существ, перед которыми у нас почти родительская обязанность заботиться.

Таким образом, у нас есть прямое моральное обязательство относиться к нашим творениям с признанием нашей особой ответственности за их радость, страдание, задумчивость и творческий потенциал. Но у нас также есть эпистемическое обязательство узнать достаточно о материальных и функциональных основах радости, страдания, размышлений и творчества, чтобы знать, когда и заслуживают ли наши потенциальные будущие творения нашу моральную заботу.

Эрик Швицгебель